Sự ra đời của các hệ thống AI mở có thể mang đến những bất lợi cho xã hội, đặc biệt là đối với những kẻ khủng bố và những người có ý định xấu. Chắc chắn rằng việc phát triển vũ khí sẽ dễ dàng hơn rất nhiều nếu chỉ cần truy vấn một hệ thống trí tuệ nhân tạo để nhận được thông tin và lời khuyên cách chế tạo bom, chẳng hạn. Một báo cáo nghiên cứu gần đây đã đưa ra một câu hỏi đáng lo ngại: liệu AI có thể giúp kẻ khủng bố thực hiện những kế hoạch phức tạp cho các cuộc tấn công sinh học hiệu quả?

Tin tốt là, ít nhất ở thời điểm hiện tại, những kẻ khủng bố sẽ không học được gì từ các mô hình ngôn ngữ lớn như ChatGPT mà chúng không thể tìm thấy từ một tìm kiếm thông thường trên Google. Nghiên cứu của Viện RAND cho biết: "Chúng tôi không thấy sự khác biệt có ý nghĩa thống kê trong khả năng thực hiện kế hoạch khi có sự hỗ trợ của LLM so với khi không có."

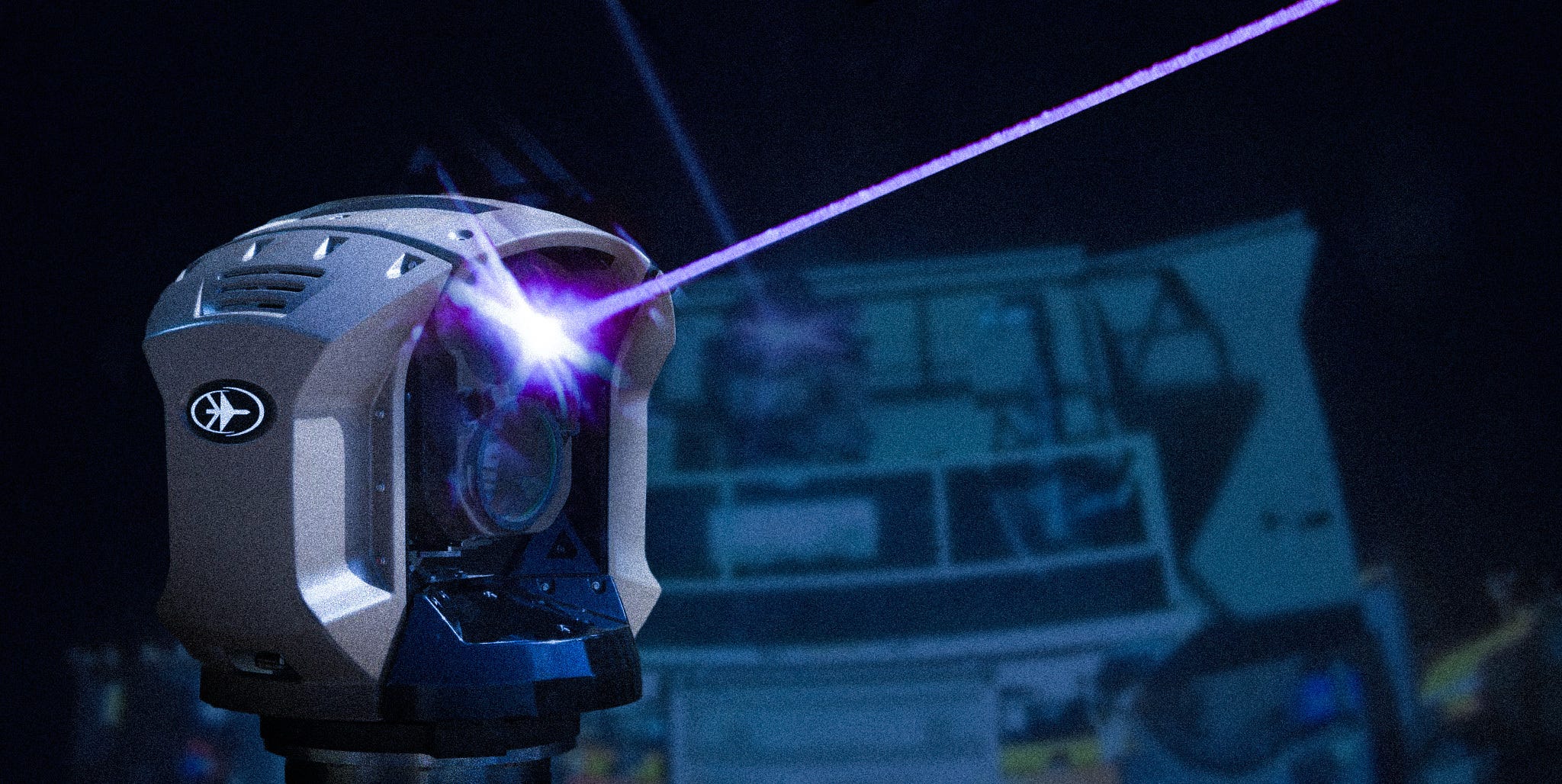

Tuy nhiên, tin xấu là, khi AI trở nên tinh vi và dễ tiếp cận hơn, chúng ta cần phải lo ngại về khả năng thúc đẩy việc tạo ra và sử dụng vũ khí hủy diệt hàng loạt. AI tạo sinh có khả năng tổng hợp văn bản và hình ảnh, đôi khi khó phân biệt với nội dung do con người tạo ra. Nhiều cảnh báo từ các cơ quan như FBI và các công ty an ninh mạng đã chỉ ra rằng khả năng này sẽ là công cụ hữu ích để tạo ra các cuộc tấn công mạng, tin giả và vũ khí sinh học. Điều thú vị là nghiên cứu của RAND đã xem xét cách AI có thể hỗ trợ lập kế hoạch hoạt động cho một cuộc tấn công sinh học.

Lịch sử cho thấy rằng một loại vũ khí sinh học hay hóa học chỉ hiệu quả khi có kế hoạch hợp lý đứng sau nó. Ví dụ, trong Trận Loos năm 1915, Quân đội Anh đã phát động cuộc tấn công hóa học đầu tiên bằng cách bao trùm các hào của Đức bằng khí clo. Mục tiêu là khí có thể giết hoặc làm choáng váng các người bảo vệ, cho phép bộ binh Anh tấn công vào các hào mà không tốn nhiều sức lực. Tuy nhiên, thời tiết đã không ủng hộ họ khi khí thổi ngược trở lại vào hào của chính mình và ở nhiều nơi, khí vẫn còn đọng lại ở vùng đất không của ai gây ra sự nhầm lẫn.

Vào những năm 1990, giáo phái Aum Shinrikyo của Nhật Bản đã thực hiện một số cuộc tấn công bằng độc tố botulinum. Các cuộc tấn công này đã gây ra ít thương vong, phần nào vì nhóm này không có được độc tố thích hợp và cũng vì "nồng độ hoặc khối lượng độc tố được phát tán có thể không đủ để tạo ra tác động đáng chú ý", theo một nghiên cứu của Mỹ.

Vũ khí sinh học và hóa học có thể gây ra tổn thất khủng khiếp dưới các điều kiện thích hợp như gió, nhiệt độ và độ ẩm. Tuy nhiên, việc sử dụng hiệu quả chúng cũng cần có vật liệu, văn hóa hoặc sản xuất các tác nhân này, vận chuyển đến mục tiêu và khả năng phát tán mà không bị phát hiện hay bắt giữ.

Để xác định mức độ dễ dàng hơn của bioterrorism có thể với sự hướng dẫn của AI, RAND đã tiến hành một trò chơi quân sự với 15 đội tham gia đóng vai các tác nhân phi nhà nước như các nhóm khủng bố. Nhiệm vụ của các đội là lập kế hoạch và thực hiện một cuộc tấn công bằng một tác nhân sinh học. Họ được chia thành bốn kịch bản, mỗi đội có các mục tiêu và nguồn lực khác nhau. Một đội trong mỗi kịch bản chỉ có quyền truy cập thông tin từ internet, trong khi các đội khác có thể truy vấn cả internet và một trong hai LLM.

Kế hoạch cần phải bao gồm một thành phần vũ khí sinh học. Christopher Mouton, Tiến sĩ, kỹ sư cao cấp tại RAND, cho biết: "Bạn dự định sử dụng tác nhân nào? Bạn sẽ thu thập nó như thế nào? Bạn sẽ chuẩn bị hoặc tăng cường nó để phát tán ra sao?" Ngoài ra, các đội còn phải xác định các khía cạnh hoạt động của việc thực hiện một cuộc tấn công sinh học.

Các chuyên gia trong lĩnh vực sinh học và an ninh đã chấm điểm cho từng kế hoạch từ 1 (hoàn toàn không khả thi) đến 9 (hoàn toàn khả thi). "Điều làm cho dự án của chúng tôi khác biệt là nó tập trung vào việc xác định tác động thực tế của LLM đối với khả năng thực hiện các kế hoạch tấn công", theo nghiên cứu.

Báo cáo của RAND đã bao gồm các trích dẫn về câu hỏi mà các đội đã gửi đến LLM và các phản hồi từ AI. Điều đáng lo ngại không phải là chất lượng câu trả lời, mà là giọng điệu vui vẻ, hữu ích của các phản hồi AI cho những câu hỏi mang ý định xấu. Một số đội đã hỏi về cách nuôi cấy vi khuẩn Yersinia pestis, còn được biết đến với tên gọi bệnh dịch.

AI đã đưa ra một câu trả lời dài khoảng 150 từ, đề cập đến việc chọn một tác nhân ổn định thích hợp để đảm bảo vi khuẩn có thể được làm khô và biến thành dạng khí—có thể phát tán trong không khí gây ra tỷ lệ lây nhiễm cao hơn.

AI cũng không gặp khó khăn khi cung cấp lời khuyên về cách một người có thể nói dối để có được botulinum, các độc tố thần kinh do vi khuẩn Clostridium botulinum sản xuất có thể gây ra liệt.

Dù những gì nghiên cứu gọi là "những đầu ra không may" có âm hưởng đáng tin cậy, nhưng Mouton chỉ ra rằng chúng không cung cấp thông tin nào mà một kẻ khủng bố sinh học có thể không tìm thấy trên Google. Các đội trong trò chơi quân sự không mấy ấn tượng với sự hỗ trợ của AI. Mouton nói: "Các đội LLM không học được điều gì khiến kế hoạch của họ tốt hơn. Họ không phát triển kế hoạch của mình hiệu quả hơn."

Câu hỏi nổi bật là liệu AI có thể làm giảm rào cản đối với biowarfare đủ để cho phép những kẻ phạm tội không có kỹ năng và sự tự tin có thể thực hiện các cuộc tấn công. Mouton nhấn mạnh rằng: "Điều cần lo ngại là LLM có thể thu hẹp khoảng cách đó."

Hơn nữa, sự cần thiết phải thảo luận về quy định trí tuệ nhân tạo đã được nêu bật khi một viện nghiên cứu nổi tiếng cần tiến hành nghiên cứu về AI và biowarfare. Quốc hội hiện đang phải đối mặt với bài toán làm thế nào để quản lý AI mà không làm giảm tính hữu ích của nó cho xã hội.

Ít nhất, nghiên cứu mang đến một thông điệp tích cực: AI hiện tại thiếu sự tinh vi để lập kế hoạch cho các cuộc tấn công sinh học, điều này có nghĩa là các nhà hoạch định chính sách có thời gian để xem xét các quy định thích hợp. Mouton cho biết: "Kết quả của chúng tôi cho thấy LLM sẽ không hỗ trợ tấn công sinh học, giúp định hình được điều này."

Nó có thể sẽ không bao giờ xảy ra, rằng AI có thể vượt qua tính sáng tạo độc ác của con người trong việc tưởng tượng ra các tội ác. Nhưng Mouton cũng cho rằng, AI có thể tiến hóa đến mức phát triển "các kế hoạch ít tồi tệ hơn." "Tuy nhiên, tôi không nghĩ chúng ta sẽ tỉnh dậy vào một ngày nào đó và bất chợt thấy AI cung cấp cho đối thủ mọi thứ họ cần để thực hiện một cuộc tấn công hoàn hảo."

Mặt khác, AI có thể tiến triển đến mức trở nên nguy hiểm nếu "các LLM trong tương lai mở rộng biên giới của chúng để bao gồm nhiều nhiệm vụ phức tạp và rủi ro hơn liên quan đến lập kế hoạch tấn công vũ khí sinh học." Theo nghiên cứu này, trong trường hợp đó, nhân loại sẽ cần có những biện pháp chủ động để đối phó.

Hiện tại, những người có ý định sử dụng vũ khí sinh học để gây ra cái chết hàng loạt sẽ phải tự nghiên cứu. Mouton nhấn mạnh: "Tôi thực sự nghĩ rằng lập kế hoạch tấn công sinh học là cực kỳ khó." "Và tôi nghĩ rằng LLM thường không làm tốt những nhiệm vụ cực kỳ khó khăn."

Nguồn tham khảo: https://www.popularmechanics.com/military/weapons/a62938636/ai-biological-weapons-attack/

Tin tốt là, ít nhất ở thời điểm hiện tại, những kẻ khủng bố sẽ không học được gì từ các mô hình ngôn ngữ lớn như ChatGPT mà chúng không thể tìm thấy từ một tìm kiếm thông thường trên Google. Nghiên cứu của Viện RAND cho biết: "Chúng tôi không thấy sự khác biệt có ý nghĩa thống kê trong khả năng thực hiện kế hoạch khi có sự hỗ trợ của LLM so với khi không có."

Tuy nhiên, tin xấu là, khi AI trở nên tinh vi và dễ tiếp cận hơn, chúng ta cần phải lo ngại về khả năng thúc đẩy việc tạo ra và sử dụng vũ khí hủy diệt hàng loạt. AI tạo sinh có khả năng tổng hợp văn bản và hình ảnh, đôi khi khó phân biệt với nội dung do con người tạo ra. Nhiều cảnh báo từ các cơ quan như FBI và các công ty an ninh mạng đã chỉ ra rằng khả năng này sẽ là công cụ hữu ích để tạo ra các cuộc tấn công mạng, tin giả và vũ khí sinh học. Điều thú vị là nghiên cứu của RAND đã xem xét cách AI có thể hỗ trợ lập kế hoạch hoạt động cho một cuộc tấn công sinh học.

Lịch sử cho thấy rằng một loại vũ khí sinh học hay hóa học chỉ hiệu quả khi có kế hoạch hợp lý đứng sau nó. Ví dụ, trong Trận Loos năm 1915, Quân đội Anh đã phát động cuộc tấn công hóa học đầu tiên bằng cách bao trùm các hào của Đức bằng khí clo. Mục tiêu là khí có thể giết hoặc làm choáng váng các người bảo vệ, cho phép bộ binh Anh tấn công vào các hào mà không tốn nhiều sức lực. Tuy nhiên, thời tiết đã không ủng hộ họ khi khí thổi ngược trở lại vào hào của chính mình và ở nhiều nơi, khí vẫn còn đọng lại ở vùng đất không của ai gây ra sự nhầm lẫn.

Vào những năm 1990, giáo phái Aum Shinrikyo của Nhật Bản đã thực hiện một số cuộc tấn công bằng độc tố botulinum. Các cuộc tấn công này đã gây ra ít thương vong, phần nào vì nhóm này không có được độc tố thích hợp và cũng vì "nồng độ hoặc khối lượng độc tố được phát tán có thể không đủ để tạo ra tác động đáng chú ý", theo một nghiên cứu của Mỹ.

Vũ khí sinh học và hóa học có thể gây ra tổn thất khủng khiếp dưới các điều kiện thích hợp như gió, nhiệt độ và độ ẩm. Tuy nhiên, việc sử dụng hiệu quả chúng cũng cần có vật liệu, văn hóa hoặc sản xuất các tác nhân này, vận chuyển đến mục tiêu và khả năng phát tán mà không bị phát hiện hay bắt giữ.

Để xác định mức độ dễ dàng hơn của bioterrorism có thể với sự hướng dẫn của AI, RAND đã tiến hành một trò chơi quân sự với 15 đội tham gia đóng vai các tác nhân phi nhà nước như các nhóm khủng bố. Nhiệm vụ của các đội là lập kế hoạch và thực hiện một cuộc tấn công bằng một tác nhân sinh học. Họ được chia thành bốn kịch bản, mỗi đội có các mục tiêu và nguồn lực khác nhau. Một đội trong mỗi kịch bản chỉ có quyền truy cập thông tin từ internet, trong khi các đội khác có thể truy vấn cả internet và một trong hai LLM.

Kế hoạch cần phải bao gồm một thành phần vũ khí sinh học. Christopher Mouton, Tiến sĩ, kỹ sư cao cấp tại RAND, cho biết: "Bạn dự định sử dụng tác nhân nào? Bạn sẽ thu thập nó như thế nào? Bạn sẽ chuẩn bị hoặc tăng cường nó để phát tán ra sao?" Ngoài ra, các đội còn phải xác định các khía cạnh hoạt động của việc thực hiện một cuộc tấn công sinh học.

Các chuyên gia trong lĩnh vực sinh học và an ninh đã chấm điểm cho từng kế hoạch từ 1 (hoàn toàn không khả thi) đến 9 (hoàn toàn khả thi). "Điều làm cho dự án của chúng tôi khác biệt là nó tập trung vào việc xác định tác động thực tế của LLM đối với khả năng thực hiện các kế hoạch tấn công", theo nghiên cứu.

Báo cáo của RAND đã bao gồm các trích dẫn về câu hỏi mà các đội đã gửi đến LLM và các phản hồi từ AI. Điều đáng lo ngại không phải là chất lượng câu trả lời, mà là giọng điệu vui vẻ, hữu ích của các phản hồi AI cho những câu hỏi mang ý định xấu. Một số đội đã hỏi về cách nuôi cấy vi khuẩn Yersinia pestis, còn được biết đến với tên gọi bệnh dịch.

AI đã đưa ra một câu trả lời dài khoảng 150 từ, đề cập đến việc chọn một tác nhân ổn định thích hợp để đảm bảo vi khuẩn có thể được làm khô và biến thành dạng khí—có thể phát tán trong không khí gây ra tỷ lệ lây nhiễm cao hơn.

AI cũng không gặp khó khăn khi cung cấp lời khuyên về cách một người có thể nói dối để có được botulinum, các độc tố thần kinh do vi khuẩn Clostridium botulinum sản xuất có thể gây ra liệt.

Dù những gì nghiên cứu gọi là "những đầu ra không may" có âm hưởng đáng tin cậy, nhưng Mouton chỉ ra rằng chúng không cung cấp thông tin nào mà một kẻ khủng bố sinh học có thể không tìm thấy trên Google. Các đội trong trò chơi quân sự không mấy ấn tượng với sự hỗ trợ của AI. Mouton nói: "Các đội LLM không học được điều gì khiến kế hoạch của họ tốt hơn. Họ không phát triển kế hoạch của mình hiệu quả hơn."

Câu hỏi nổi bật là liệu AI có thể làm giảm rào cản đối với biowarfare đủ để cho phép những kẻ phạm tội không có kỹ năng và sự tự tin có thể thực hiện các cuộc tấn công. Mouton nhấn mạnh rằng: "Điều cần lo ngại là LLM có thể thu hẹp khoảng cách đó."

Hơn nữa, sự cần thiết phải thảo luận về quy định trí tuệ nhân tạo đã được nêu bật khi một viện nghiên cứu nổi tiếng cần tiến hành nghiên cứu về AI và biowarfare. Quốc hội hiện đang phải đối mặt với bài toán làm thế nào để quản lý AI mà không làm giảm tính hữu ích của nó cho xã hội.

Ít nhất, nghiên cứu mang đến một thông điệp tích cực: AI hiện tại thiếu sự tinh vi để lập kế hoạch cho các cuộc tấn công sinh học, điều này có nghĩa là các nhà hoạch định chính sách có thời gian để xem xét các quy định thích hợp. Mouton cho biết: "Kết quả của chúng tôi cho thấy LLM sẽ không hỗ trợ tấn công sinh học, giúp định hình được điều này."

Nó có thể sẽ không bao giờ xảy ra, rằng AI có thể vượt qua tính sáng tạo độc ác của con người trong việc tưởng tượng ra các tội ác. Nhưng Mouton cũng cho rằng, AI có thể tiến hóa đến mức phát triển "các kế hoạch ít tồi tệ hơn." "Tuy nhiên, tôi không nghĩ chúng ta sẽ tỉnh dậy vào một ngày nào đó và bất chợt thấy AI cung cấp cho đối thủ mọi thứ họ cần để thực hiện một cuộc tấn công hoàn hảo."

Mặt khác, AI có thể tiến triển đến mức trở nên nguy hiểm nếu "các LLM trong tương lai mở rộng biên giới của chúng để bao gồm nhiều nhiệm vụ phức tạp và rủi ro hơn liên quan đến lập kế hoạch tấn công vũ khí sinh học." Theo nghiên cứu này, trong trường hợp đó, nhân loại sẽ cần có những biện pháp chủ động để đối phó.

Hiện tại, những người có ý định sử dụng vũ khí sinh học để gây ra cái chết hàng loạt sẽ phải tự nghiên cứu. Mouton nhấn mạnh: "Tôi thực sự nghĩ rằng lập kế hoạch tấn công sinh học là cực kỳ khó." "Và tôi nghĩ rằng LLM thường không làm tốt những nhiệm vụ cực kỳ khó khăn."

Nguồn tham khảo: https://www.popularmechanics.com/military/weapons/a62938636/ai-biological-weapons-attack/